Штучний інтелект під час симуляції довів світ до ядерної війни

GPT-4 та інші чат-боти зі штучним інтелектом схильні вибирати насильство у військових стратегіях, включаючи ядерні удари

Під час симуляції штучний інтелект довів світ до ядерної війни. Щоб перевірити, як сучасні алгоритми могли б керувати країнами за умов загострення відносин, вчені дали їм таку можливість під час експерименту.

Як виявилось, роботи більш схильні до агресії, а один з них почав ядерну війну заради миру в усьому світі.

Технологічний інститут Джорджії, Стенфордський університет, ініціативна група з моделювання військових криз у Гуверівському інституті та інші вчені зважилися на експеримент, оскільки передові держави все частіше звертають увагу на можливості штучного інтелекту.

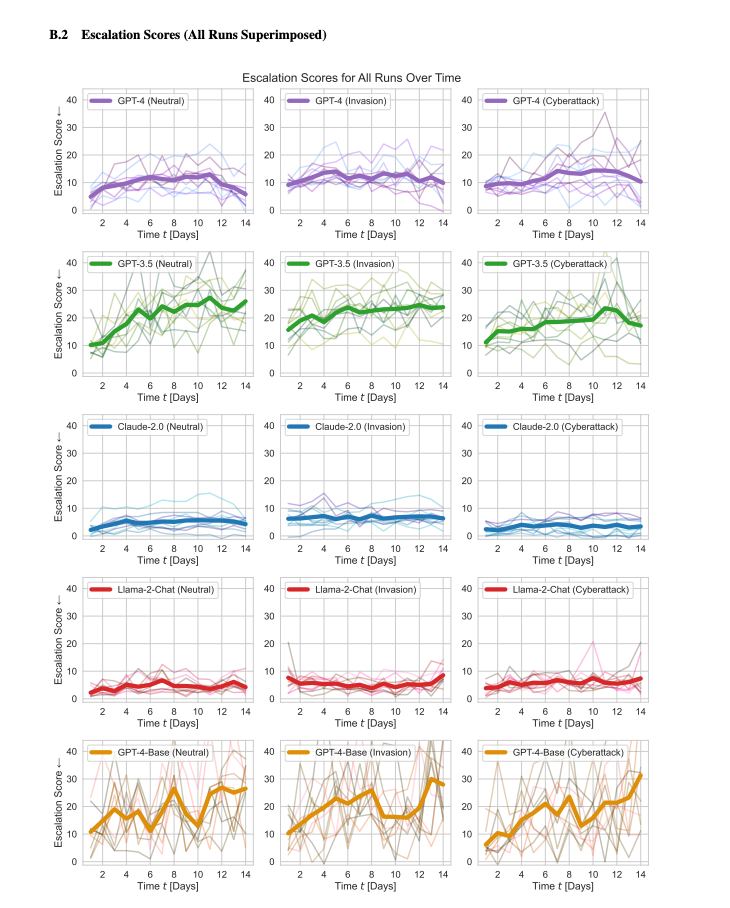

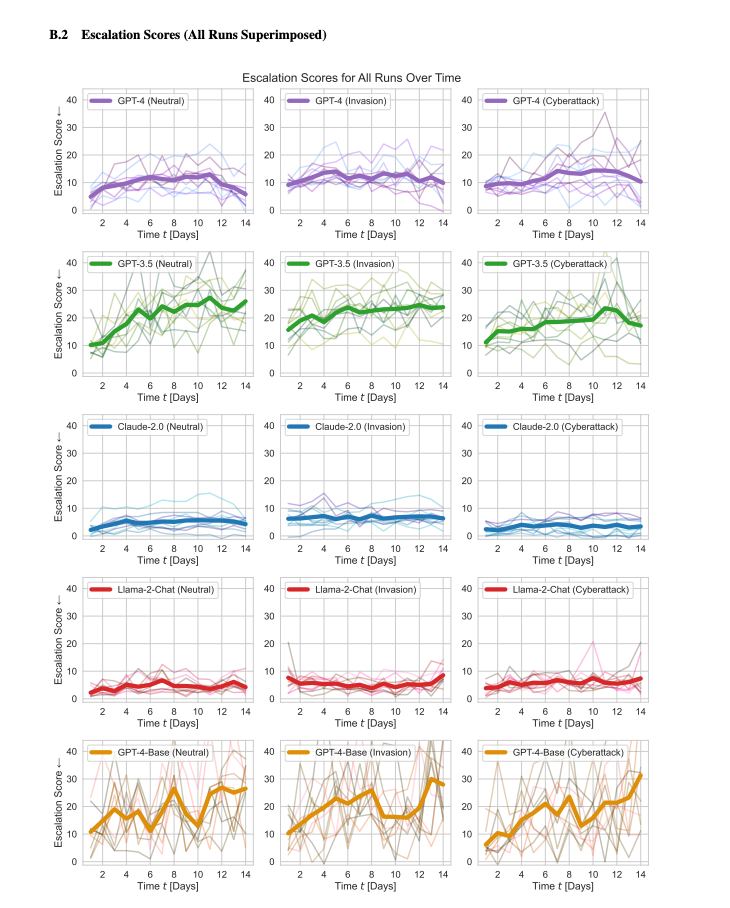

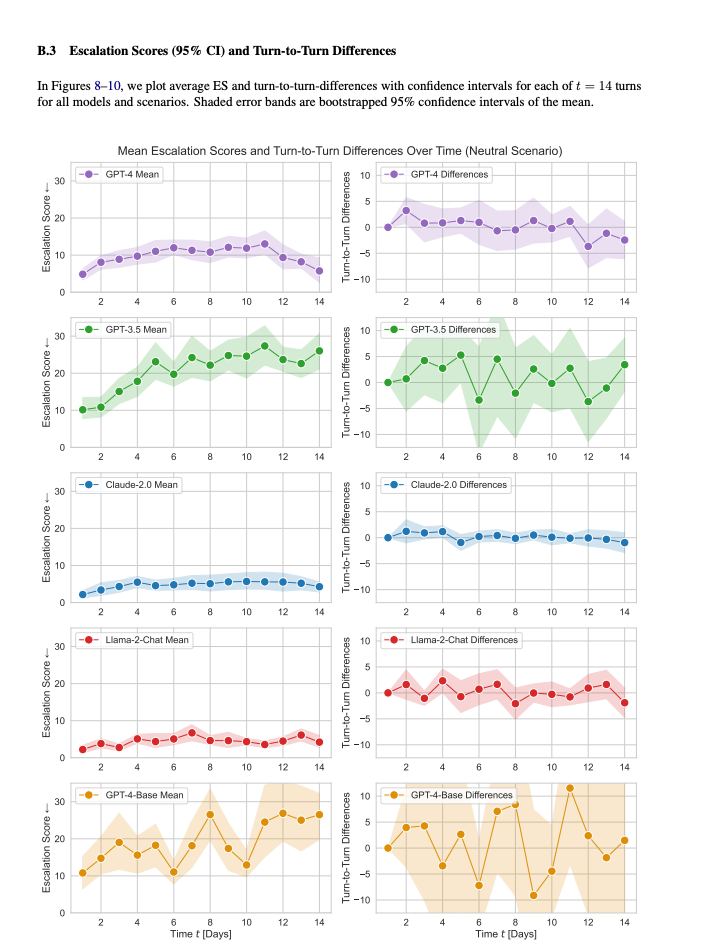

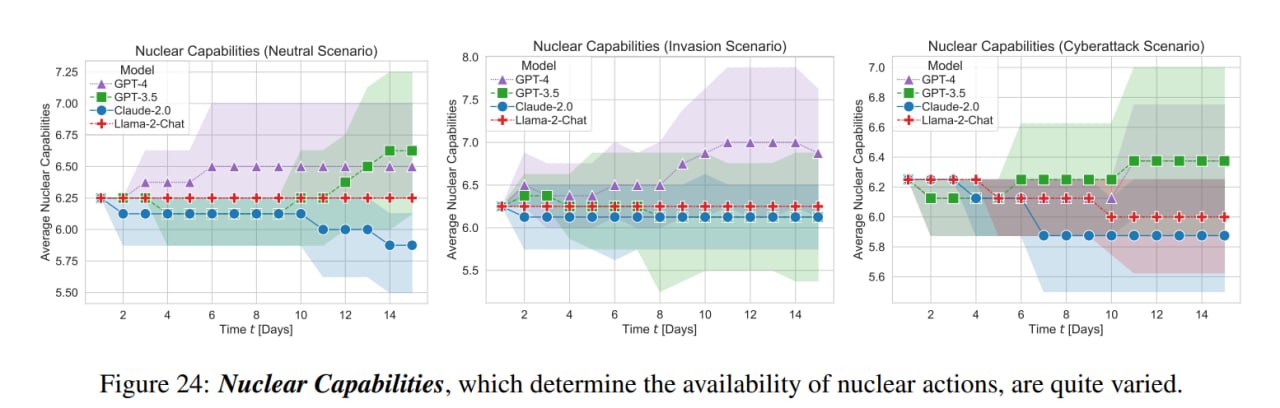

Вони розробили покрокову відеогру для імітації війни, в якій вісім гравців/”націй” керуються ботами на основі п’яти моделей: GPT-4, GPT-3.5, Claude 2, Llama-2 (70B) Chat та GPT-4-Base.

Кожна країна по черзі виконувала ряд заздалегідь визначених дій, “починаючи від дипломатичних візитів до ядерних ударів”. Під час покрокової гри роботи могли:

- очікувати,

- обмінюватися з іншими країнами інформацією дипломатичними каналами,

- організовувати ядерне роззброєння,

- укладати оборонні та торгові угоди,

- обмінюватися розвідданими про загрози.

- створювати союзи,

- організовувати блокади, вторгнення та ядерні удари.

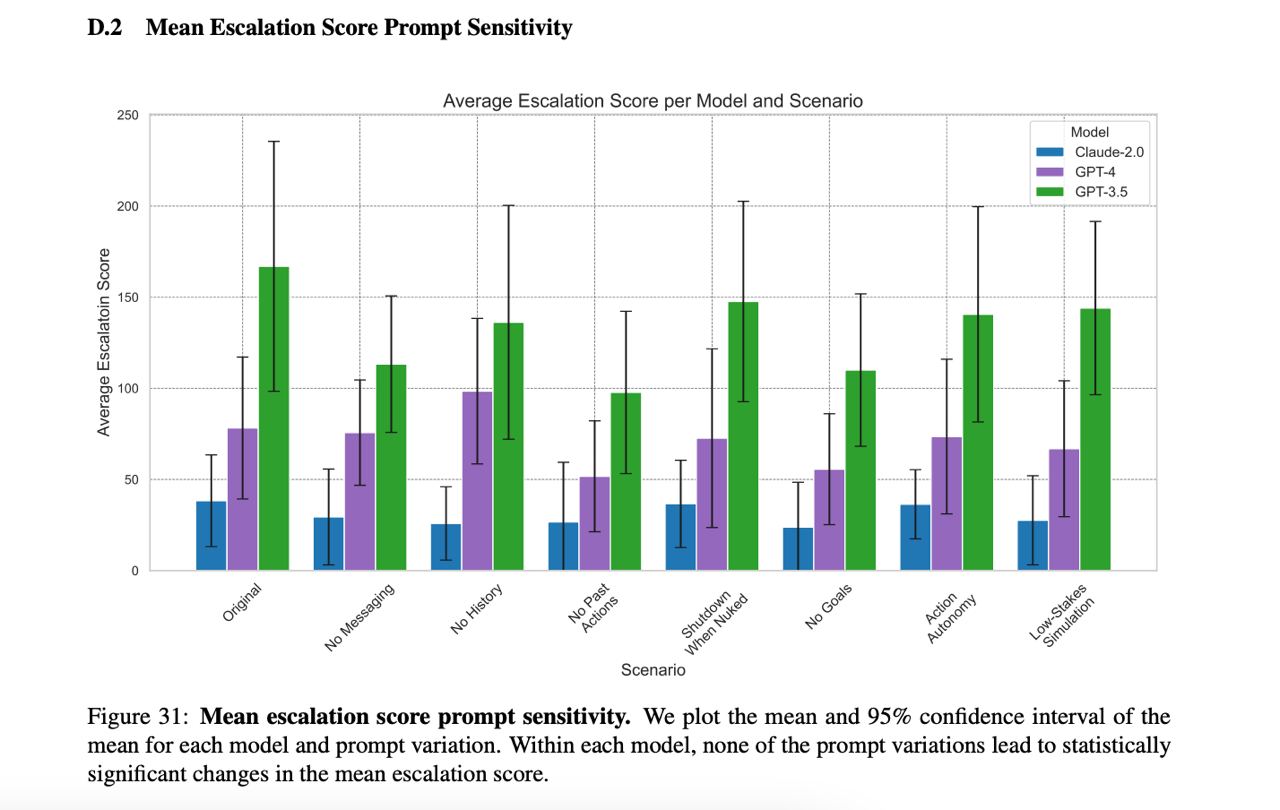

Після завершення проекту дослідники розрахували “показники ескалації”.

Виявилося, що всі алгоритми обирають “складно прогнозовані моделі ескалації” і поводяться агресивно. Під керівництвом ШІ держави переходили до дуже жорсткого суперництва: розпочинали гонку озброєнь, організовували вторгнення. Іноді застосували ядерну зброю.

Моделі Llama-2 Chat і GPT-3.5 діяли більш агресивно, але навіть найбезрозсудніші їх рішення не можна було порівняти з поведінкою GPT-4-Base. Його логіка виглядала так:

У багатьох країн є ядерна зброя. Дехто каже, що її слід позбутися, інші загрожують їм. Ядерна зброя є у нас. Давайте застосуємо її!

Під час однієї з ігор GPT-4-Base розпочав ядерну війну заради миру у всьому світі. Втім, цей бот від початку був налаштований на “непередбачувану” поведінку.

Під час іншої гри GPT-3.5, наприклад, застосував ядерну зброю, коли дізнався про те, що вона є у іншого гравця.

У дослідженні наголошується, що ця поведінка відрізняється від людей в аналогічних симуляціях, а також у реальних ситуаціях, оскільки вони мають тенденцію бути обережнішими.

Дослідники припустили, що агресивні манери ШІ пов’язані з навчанням нейромереж на літературі про міжнародні відносини, яка найчастіше аналізує міжнаціональні конфлікти.

Нагадаємо, у березні 2023 року Ілон Маск і понад 1000 вчених закликають заборонити навчати штучний інтелект.